搜索到

89

篇与

的结果

-

飞牛遇到的一些问题 1. 个人空间与实际使用不符合#!/bin/bash btrfs quota rescan -w /vol12. 回收站内容不会自动清理比如我需要清理的是网络备份这个回收站目录下的文件#!/bin/bash # 定义要清理的目录 TRASH_DIR="/vol2/1000/.@#local/trash/网络备份" # 定义日志文件位置 LOG_FILE="/vol2/1000/网络备份/clean_network_back.log" # 获取当前时间,用于日志记录 echo "=== 清理任务开始于 $(date) ===" >> "$LOG_FILE" 2>&1 # 检查目标目录是否存在 if [ -d "$TRASH_DIR" ]; then # 计算清理前的目录大小 BEFORE_SIZE=$(du -sb "$TRASH_DIR" 2>/dev/null | cut -f1) BEFORE_SIZE=${BEFORE_SIZE:-0} # 如果目录为空或不存在,设为0 # 执行删除操作,强制删除目录下的所有文件和子目录 # 使用 /bin/rm 的绝对路径以避免别名问题 /bin/rm -rf -- "$TRASH_DIR"/* >> "$LOG_FILE" 2>&1 # 计算清理后的目录大小 AFTER_SIZE=$(du -sb "$TRASH_DIR" 2>/dev/null | cut -f1) AFTER_SIZE=${AFTER_SIZE:-0} # 如果目录为空或不存在,设为0 # 计算释放的空间(字节) FREED_SPACE=$((BEFORE_SIZE - AFTER_SIZE)) # 格式化显示空间大小 format_size() { local bytes=$1 if [ $bytes -ge 1073741824 ]; then echo "$(echo "scale=2; $bytes/1073741824" | bc) GB" elif [ $bytes -ge 1048576 ]; then echo "$(echo "scale=2; $bytes/1048576" | bc) MB" elif [ $bytes -ge 1024 ]; then echo "$(echo "scale=2; $bytes/1024" | bc) KB" else echo "${bytes} B" fi } FREED_SPACE_FORMATTED=$(format_size $FREED_SPACE) echo "成功清理目录 $TRASH_DIR 下的所有内容。" >> "$LOG_FILE" 2>&1 echo "释放空间: $FREED_SPACE_FORMATTED" >> "$LOG_FILE" 2>&1 echo "清理详情: 清理前 $(format_size $BEFORE_SIZE), 清理后 $(format_size $AFTER_SIZE)" >> "$LOG_FILE" 2>&1 else echo "错误:目录 $TRASH_DIR 不存在,清理任务已中止。" >> "$LOG_FILE" 2>&1 fi echo "=== 清理任务结束于 $(date) ===" >> "$LOG_FILE" 2>&1 echo "" >> "$LOG_FILE" 2>&1将脚本放到某个目录下,比如我的放到的是**/网络备份/clean_network_back.sh使用crontab来做定时任务# 查看当前任务 crontab -l # 编辑任务 crontab -e增加一行# 分别对应秒分时天月 0 8 * * * /vol2/1000/网络备份/clean_network_back.sh

飞牛遇到的一些问题 1. 个人空间与实际使用不符合#!/bin/bash btrfs quota rescan -w /vol12. 回收站内容不会自动清理比如我需要清理的是网络备份这个回收站目录下的文件#!/bin/bash # 定义要清理的目录 TRASH_DIR="/vol2/1000/.@#local/trash/网络备份" # 定义日志文件位置 LOG_FILE="/vol2/1000/网络备份/clean_network_back.log" # 获取当前时间,用于日志记录 echo "=== 清理任务开始于 $(date) ===" >> "$LOG_FILE" 2>&1 # 检查目标目录是否存在 if [ -d "$TRASH_DIR" ]; then # 计算清理前的目录大小 BEFORE_SIZE=$(du -sb "$TRASH_DIR" 2>/dev/null | cut -f1) BEFORE_SIZE=${BEFORE_SIZE:-0} # 如果目录为空或不存在,设为0 # 执行删除操作,强制删除目录下的所有文件和子目录 # 使用 /bin/rm 的绝对路径以避免别名问题 /bin/rm -rf -- "$TRASH_DIR"/* >> "$LOG_FILE" 2>&1 # 计算清理后的目录大小 AFTER_SIZE=$(du -sb "$TRASH_DIR" 2>/dev/null | cut -f1) AFTER_SIZE=${AFTER_SIZE:-0} # 如果目录为空或不存在,设为0 # 计算释放的空间(字节) FREED_SPACE=$((BEFORE_SIZE - AFTER_SIZE)) # 格式化显示空间大小 format_size() { local bytes=$1 if [ $bytes -ge 1073741824 ]; then echo "$(echo "scale=2; $bytes/1073741824" | bc) GB" elif [ $bytes -ge 1048576 ]; then echo "$(echo "scale=2; $bytes/1048576" | bc) MB" elif [ $bytes -ge 1024 ]; then echo "$(echo "scale=2; $bytes/1024" | bc) KB" else echo "${bytes} B" fi } FREED_SPACE_FORMATTED=$(format_size $FREED_SPACE) echo "成功清理目录 $TRASH_DIR 下的所有内容。" >> "$LOG_FILE" 2>&1 echo "释放空间: $FREED_SPACE_FORMATTED" >> "$LOG_FILE" 2>&1 echo "清理详情: 清理前 $(format_size $BEFORE_SIZE), 清理后 $(format_size $AFTER_SIZE)" >> "$LOG_FILE" 2>&1 else echo "错误:目录 $TRASH_DIR 不存在,清理任务已中止。" >> "$LOG_FILE" 2>&1 fi echo "=== 清理任务结束于 $(date) ===" >> "$LOG_FILE" 2>&1 echo "" >> "$LOG_FILE" 2>&1将脚本放到某个目录下,比如我的放到的是**/网络备份/clean_network_back.sh使用crontab来做定时任务# 查看当前任务 crontab -l # 编辑任务 crontab -e增加一行# 分别对应秒分时天月 0 8 * * * /vol2/1000/网络备份/clean_network_back.sh -

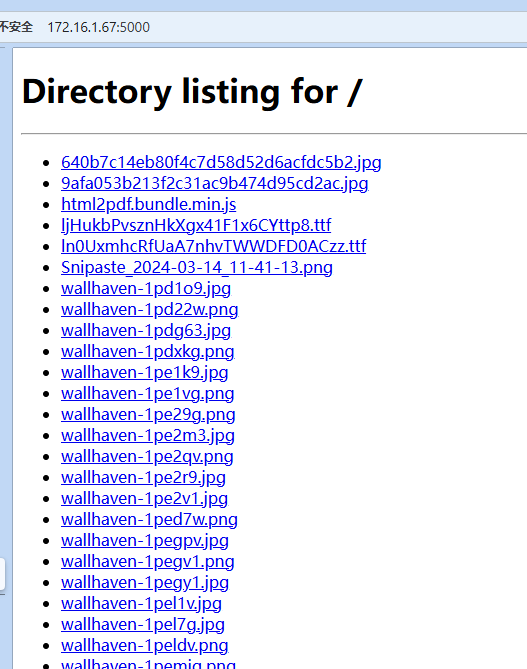

Python极速搭建局域网文件传输服务器 在日常工作中,是否遇到下面的困扰:同事急需你电脑上的资料文件,却找不到U盘聊天工具传输速度慢,文件类型受限云存储等第三方工具存在隐私泄露风险,还需要复杂配置今天我们使用Python内置神器,3秒搭建局域网文件共享服务器!你没看错,就是3秒!核心武器:HTTP服务器模块Python自带了一个强大的模块http.server,只需要一条命令就能启动文件共享服务器# 在文件所在目录执行 python -m http.server默认端口8000,浏览器访问http://your_ip:8000,就可以查看当前目录下的所有文件实测传输1GB的文件用时不到10s(千兆局域网环境)手机连接同一个局域网,同样也能在浏览器访问服务端可以查看到所有的访问记录(如上图所示)进阶使用技巧1.自定义端口将默认的8000端口替换为其他未被占用的端口python -m http.server 78792.自定义共享目录设置共享的根目录# Linux/Mac共享/share文件夹 python3 -m http.server -d /share 7879 # Windows共享D:\share文件夹 python -m http.server -d D:\share 78793.多线程性能优化http.server默认为单线程,多人使用有高并发阻塞风险,可使用socketserver.ThreadingTCPServerimport socketserver from http.server import SimpleHTTPRequestHandler handler = SimpleHTTPRequestHandler with socketserver.ThreadingTCPServer(('', 7879), handler) as httpd: httpd.serve_forever()安全提示:使用完毕后请及时关闭文件共享服务(关闭cmd命令终端窗口即可),避免长期暴露文件技术不在于复杂,而在于解决实际问题。下次需要共享文件时,无需聊天工具来回发送,也不必寻找U盘,只需打开终端,一行命令开启专属高速文件共享通道!

Python极速搭建局域网文件传输服务器 在日常工作中,是否遇到下面的困扰:同事急需你电脑上的资料文件,却找不到U盘聊天工具传输速度慢,文件类型受限云存储等第三方工具存在隐私泄露风险,还需要复杂配置今天我们使用Python内置神器,3秒搭建局域网文件共享服务器!你没看错,就是3秒!核心武器:HTTP服务器模块Python自带了一个强大的模块http.server,只需要一条命令就能启动文件共享服务器# 在文件所在目录执行 python -m http.server默认端口8000,浏览器访问http://your_ip:8000,就可以查看当前目录下的所有文件实测传输1GB的文件用时不到10s(千兆局域网环境)手机连接同一个局域网,同样也能在浏览器访问服务端可以查看到所有的访问记录(如上图所示)进阶使用技巧1.自定义端口将默认的8000端口替换为其他未被占用的端口python -m http.server 78792.自定义共享目录设置共享的根目录# Linux/Mac共享/share文件夹 python3 -m http.server -d /share 7879 # Windows共享D:\share文件夹 python -m http.server -d D:\share 78793.多线程性能优化http.server默认为单线程,多人使用有高并发阻塞风险,可使用socketserver.ThreadingTCPServerimport socketserver from http.server import SimpleHTTPRequestHandler handler = SimpleHTTPRequestHandler with socketserver.ThreadingTCPServer(('', 7879), handler) as httpd: httpd.serve_forever()安全提示:使用完毕后请及时关闭文件共享服务(关闭cmd命令终端窗口即可),避免长期暴露文件技术不在于复杂,而在于解决实际问题。下次需要共享文件时,无需聊天工具来回发送,也不必寻找U盘,只需打开终端,一行命令开启专属高速文件共享通道! -

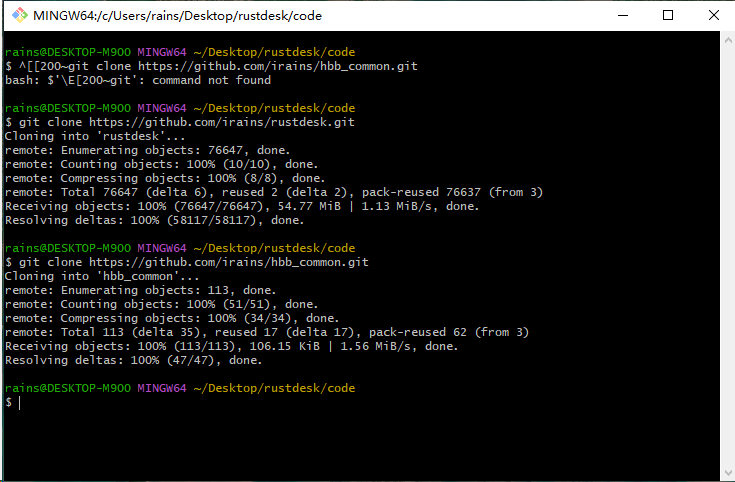

使用GitHub Action 自动构建 RustDesk 客户端 1. 安装rustdeskdocker-compose 文件:假设你的域名是rustdesk.test.comservices: rustdeskapi: container_name: rustdeskapi ports: - 21114:21114 - 21115:21115 - 21116:21116 - 21116:21116/udp - 21117:21117 - 21118:21118 - 21119:21119 image: lejianwen/rustdesk-server-s6:latest environment: RELAY: "rustdesk.test.com:21117" #中继服务器:21117 ENCRYPTED_ONLY: 1 MUST_LOGIN: Y #默认为N,设置为Y 则必须登录才能链接 TZ: Asia/Shanghai RUSTDESK_API_RUSTDESK_ID_SERVER: "rustdesk.test.com:21116" #ID服务器 RUSTDESK_API_RUSTDESK_API_SERVER: "https://rustdesk.test.com" #API服务器 RUSTDESK_API_RUSTDESK_KEY: "" # 首次运行后给的 RUSTDESK_API_JWT_KEY: "随便一个" # 自定义JWT KEY,为空则不启用JWT,如果没使用lejianwen/rustdesk-server中的MUST_LOGIN,建议设置为空 RUSTDESK_API_RUSTDESK_WS_HOST: "wss://rustdesk.test.com" volumes: - ./server:/data - ./api:/app/data #将数据库挂载 restart: unless-stoppednginx文件:参考:HTTPS Reverse Proxy · lejianwen/rustdesk-api Wikiserver { server_name <server>; listen 443 ssl; ssl_certificate /etc/nginx/ssl/<server>/fullchain.pem; ssl_certificate_key /etc/nginx/ssl/<server>/privkey.pem; location / { proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_pass http://rustdesk-api:21114/; } location /ws/id { proxy_pass http://rustdesk-server:21118; proxy_http_version 1.1; proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "Upgrade"; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; } location /ws/relay { proxy_pass http://rustdesk-server:21119; proxy_http_version 1.1; proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "Upgrade"; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; } } server { if ($host = <server>) { return 301 https://$host$request_uri; } server_name <server>; listen 80; return 404; }2. Fork Rustdesk仓库rustdesk/hbb_commonrustdesk/rustdesk2.1 拉取 Fork 后的代码请注意,替换仓库地址为你fork后的仓库地址,而不是直接复制我下面的命令 # 可选:如果需要使用代理 # git config --global http.proxy http://127.0.0.1:10808 # git config --global https.proxy http://127.0.0.1:10808 # 拉取仓库代码到本地 请替换为你fork后的仓库地址 git clone https://github.com/irains/hbb_common.git git clone https://github.com/irains/rustdesk.git 3. 修改 hbb_common代码打开 hbb_common 仓库下的 src/config.rs文件,修改 101-102 行 的默认服务器和密钥为你自己的服务器和密钥。 3.1 推送修改后的代码# 将修改的代码添加到暂存区 git add . # 将代码提交到本地仓库 git commit -m "修改默认的服务器和 key" # 将本地仓库代码推送到远程仓库 如果你没有登录过GitHub会要求你登录github git push 3.2 查看最新提交的 commit IDgit log --oneline我这里提交后的commit id是b8d80ca,可用于后续验证rustdesk服务器和key是否修改成功4. 修改 rustdesk 仓库代码我们切换到克隆下来的rustdesk代码目录下,按照下面的方式修改子模块地址并更新。4.1 更新 .gitmodules打开并编辑 .gitmodules 文件,将 url 替换为你Fork后的 hbb_common 仓库地址。比如我fork后的仓库地址是https://github.com/irains/hbb_common\则将 https://github.com/rustdesk/hbb_common地址换为前面这个地址即可,记住是hbb_common的地址,而不是rustdesk仓库的地址4.2 更新子模块将上面修改好的代码保存,执行下面的命令更新子模块到最新的commit idgit submodule sync git submodule update --remote如果上面的方法不行,用下面这个cd libs/hbb_common git checkout <上面提到的版本号> cd ../.. git add libs/hbb_common git commit -m "Pin submodule to specific version"4.3 提交并推送代码git add . git commit -m "修改子模块仓库地址" git push4.4 确认 Commit ID 更新代码推送完毕后,进入你Fork 后的 rustdesk 仓库的 libs 目录下,查看 hbb_common 后面的 commit id,确保它是3.2提到的b8d80ca(这个值每个人的是不同的),否则请回到上面的步骤重新检查是否遗漏了某个操作。 5. 触发 GitHub Action 构建5.1 创建 Tag在本地 rustdesk 仓库中创建一个新 tag,例如 1.3.9,请使用 固定格式 (如 1.3.9 或 v1.3.9),以便于自动匹配构建规则。git tag -a 1.3.9 -m "修改内置服务器和 key"5.2 增加API_SERVER来到rustdesk项目,settings --> Secrets and variables --> new repository secretname:API_SERVERsecret:RUSTDESK_API_RUSTDESK_API_SERVER的值5.3 触发 GitHub Actions 构建在 rustdesk 仓库中,进入 Actions 页面,点击下面图中的按钮启用自动构建。启用后回到本地rustdesk代码中使用下面的命令将tag推送到Github后将自动开始构建。git push --tags5.4 下载构建好的客户端Tag推送完毕后会出现下面的构建进度。 等待 Action 执行完成后(时间比较长,一个半小时左右才能全部构建完成),进入 Releases 页面,即可下载构建好的客户端并使用。

使用GitHub Action 自动构建 RustDesk 客户端 1. 安装rustdeskdocker-compose 文件:假设你的域名是rustdesk.test.comservices: rustdeskapi: container_name: rustdeskapi ports: - 21114:21114 - 21115:21115 - 21116:21116 - 21116:21116/udp - 21117:21117 - 21118:21118 - 21119:21119 image: lejianwen/rustdesk-server-s6:latest environment: RELAY: "rustdesk.test.com:21117" #中继服务器:21117 ENCRYPTED_ONLY: 1 MUST_LOGIN: Y #默认为N,设置为Y 则必须登录才能链接 TZ: Asia/Shanghai RUSTDESK_API_RUSTDESK_ID_SERVER: "rustdesk.test.com:21116" #ID服务器 RUSTDESK_API_RUSTDESK_API_SERVER: "https://rustdesk.test.com" #API服务器 RUSTDESK_API_RUSTDESK_KEY: "" # 首次运行后给的 RUSTDESK_API_JWT_KEY: "随便一个" # 自定义JWT KEY,为空则不启用JWT,如果没使用lejianwen/rustdesk-server中的MUST_LOGIN,建议设置为空 RUSTDESK_API_RUSTDESK_WS_HOST: "wss://rustdesk.test.com" volumes: - ./server:/data - ./api:/app/data #将数据库挂载 restart: unless-stoppednginx文件:参考:HTTPS Reverse Proxy · lejianwen/rustdesk-api Wikiserver { server_name <server>; listen 443 ssl; ssl_certificate /etc/nginx/ssl/<server>/fullchain.pem; ssl_certificate_key /etc/nginx/ssl/<server>/privkey.pem; location / { proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_pass http://rustdesk-api:21114/; } location /ws/id { proxy_pass http://rustdesk-server:21118; proxy_http_version 1.1; proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "Upgrade"; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; } location /ws/relay { proxy_pass http://rustdesk-server:21119; proxy_http_version 1.1; proxy_set_header Upgrade $http_upgrade; proxy_set_header Connection "Upgrade"; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; proxy_set_header X-Forwarded-Proto $scheme; } } server { if ($host = <server>) { return 301 https://$host$request_uri; } server_name <server>; listen 80; return 404; }2. Fork Rustdesk仓库rustdesk/hbb_commonrustdesk/rustdesk2.1 拉取 Fork 后的代码请注意,替换仓库地址为你fork后的仓库地址,而不是直接复制我下面的命令 # 可选:如果需要使用代理 # git config --global http.proxy http://127.0.0.1:10808 # git config --global https.proxy http://127.0.0.1:10808 # 拉取仓库代码到本地 请替换为你fork后的仓库地址 git clone https://github.com/irains/hbb_common.git git clone https://github.com/irains/rustdesk.git 3. 修改 hbb_common代码打开 hbb_common 仓库下的 src/config.rs文件,修改 101-102 行 的默认服务器和密钥为你自己的服务器和密钥。 3.1 推送修改后的代码# 将修改的代码添加到暂存区 git add . # 将代码提交到本地仓库 git commit -m "修改默认的服务器和 key" # 将本地仓库代码推送到远程仓库 如果你没有登录过GitHub会要求你登录github git push 3.2 查看最新提交的 commit IDgit log --oneline我这里提交后的commit id是b8d80ca,可用于后续验证rustdesk服务器和key是否修改成功4. 修改 rustdesk 仓库代码我们切换到克隆下来的rustdesk代码目录下,按照下面的方式修改子模块地址并更新。4.1 更新 .gitmodules打开并编辑 .gitmodules 文件,将 url 替换为你Fork后的 hbb_common 仓库地址。比如我fork后的仓库地址是https://github.com/irains/hbb_common\则将 https://github.com/rustdesk/hbb_common地址换为前面这个地址即可,记住是hbb_common的地址,而不是rustdesk仓库的地址4.2 更新子模块将上面修改好的代码保存,执行下面的命令更新子模块到最新的commit idgit submodule sync git submodule update --remote如果上面的方法不行,用下面这个cd libs/hbb_common git checkout <上面提到的版本号> cd ../.. git add libs/hbb_common git commit -m "Pin submodule to specific version"4.3 提交并推送代码git add . git commit -m "修改子模块仓库地址" git push4.4 确认 Commit ID 更新代码推送完毕后,进入你Fork 后的 rustdesk 仓库的 libs 目录下,查看 hbb_common 后面的 commit id,确保它是3.2提到的b8d80ca(这个值每个人的是不同的),否则请回到上面的步骤重新检查是否遗漏了某个操作。 5. 触发 GitHub Action 构建5.1 创建 Tag在本地 rustdesk 仓库中创建一个新 tag,例如 1.3.9,请使用 固定格式 (如 1.3.9 或 v1.3.9),以便于自动匹配构建规则。git tag -a 1.3.9 -m "修改内置服务器和 key"5.2 增加API_SERVER来到rustdesk项目,settings --> Secrets and variables --> new repository secretname:API_SERVERsecret:RUSTDESK_API_RUSTDESK_API_SERVER的值5.3 触发 GitHub Actions 构建在 rustdesk 仓库中,进入 Actions 页面,点击下面图中的按钮启用自动构建。启用后回到本地rustdesk代码中使用下面的命令将tag推送到Github后将自动开始构建。git push --tags5.4 下载构建好的客户端Tag推送完毕后会出现下面的构建进度。 等待 Action 执行完成后(时间比较长,一个半小时左右才能全部构建完成),进入 Releases 页面,即可下载构建好的客户端并使用。 -

-

rclone 配置同步 配置 MinIO 连接示例:n) New remote name> myminio Storage> s3 provider> Other env_auth> false access_key_id> YOUR_MINIO_ACCESS_KEY secret_access_key> YOUR_MINIO_SECRET_KEY region> us-east-1 endpoint> http://your-minio-server:9000 location_constraint> acl> storage_class> 配置 AWS S3 连接示例:n) New remote name> mys3 Storage> s3 provider> AWS env_auth> false access_key_id> YOUR_AWS_ACCESS_KEY secret_access_key> YOUR_AWS_SECRET_KEY region> ap-northeast-1 endpoint> location_constraint> acl> storage_class> 基本同步命令单向同步(MinIO → S3)rclone sync myminio:bucket1 mys3:bucket2双向同步(保持两端一致)rclone bisync myminio:bucket1 mys3:bucket2高级同步选项增量同步(只传输变化的部分)rclone sync --update myminio:bucket1 mys3:bucket2

rclone 配置同步 配置 MinIO 连接示例:n) New remote name> myminio Storage> s3 provider> Other env_auth> false access_key_id> YOUR_MINIO_ACCESS_KEY secret_access_key> YOUR_MINIO_SECRET_KEY region> us-east-1 endpoint> http://your-minio-server:9000 location_constraint> acl> storage_class> 配置 AWS S3 连接示例:n) New remote name> mys3 Storage> s3 provider> AWS env_auth> false access_key_id> YOUR_AWS_ACCESS_KEY secret_access_key> YOUR_AWS_SECRET_KEY region> ap-northeast-1 endpoint> location_constraint> acl> storage_class> 基本同步命令单向同步(MinIO → S3)rclone sync myminio:bucket1 mys3:bucket2双向同步(保持两端一致)rclone bisync myminio:bucket1 mys3:bucket2高级同步选项增量同步(只传输变化的部分)rclone sync --update myminio:bucket1 mys3:bucket2 -

minio命令 客户端配置# 配置别名(连接远程MinIO服务器) mc alias set myminio http://localhost:9000 ACCESS_KEY SECRET_KEY # 示例: mc alias set myminio http://127.0.0.1:9000 username password # 列出所有配置的别名 mc alias list存储桶操作# 创建存储桶 mc mb myminio/mybucket # 列出所有存储桶 mc ls myminio # 删除空存储桶 mc rb myminio/mybucket # 强制删除非空存储桶 mc rb --force myminio/mybucket对象操作# 上传文件 mc cp localfile.txt myminio/mybucket/ # 下载文件 mc cp myminio/mybucket/remotefile.txt . # 列出存储桶内容 mc ls myminio/mybucket # 删除对象 mc rm myminio/mybucket/file.txt # 递归删除目录 mc rm --recursive myminio/mybucket/mydir策略管理# 设置存储桶为公开可读 mc anonymous set download myminio/mybucket # 设置存储桶为私有 mc anonymous set none myminio/mybucket # 添加用户 mc admin user add myminio newuser newpassword # 设置用户策略 mc admin policy set myminio readwrite user=newuser监控与维护# 查看服务器信息 mc admin info myminio # 查看服务健康状态 mc admin heal myminio # 查看存储桶使用情况 mc du myminio/mybucket高级功能# 设置对象保留策略 mc retention set --default GOVERNANCE 30d myminio/mybucket # 设置对象锁定(合规模式) mc retention set --default COMPLIANCE 30d myminio/mybucket # 启用版本控制 mc version enable myminio/mybucket # 列出对象版本 mc ls --versions myminio/mybucket管理用户mc admin user # 创建用户 mc admin user add <alias> <username> <password> # 示例:创建名为reports的用户 mc admin user add myminio reports user123456 # 列出所有用户 mc admin user list <alias> # 示例:列出myminio的所有用户 mc admin user list myminio # 查看用户信息 mc admin user info <alias> <username> # 示例:查看reports用户信息 mc admin user info myminio reports # 禁用用户 mc admin user disable <alias> <username> # 示例:禁用reports用户 mc admin user disable myminio reports # 启用用户 mc admin user enable <alias> <username> # 示例:重新启用reports用户 mc admin user enable myminio reports # 删除用户 mc admin user remove <alias> <username> # 示例:删除reports用户 mc admin user remove myminio reports用户策略管理# 为用户分配策略 mc admin policy attach <alias> <policy-name> --user=<username> # 示例:为reports用户分配readonly策略 mc admin policy attach myminio readonly --user=reports # 查看用户当前策略 mc admin policy info <alias> --user=<username> # 示例:查看reports用户的策略 mc admin policy info myminio --user=reports # 解除用户策略 mc admin policy detach <alias> <policy-name> --user=<username> # 示例:移除reports用户的readonly策略 mc admin policy detach myminio readonly --user=reports用户密钥管理# 修改用户密码 mc admin user update <alias> <username> <new-password> # 示例:修改reports用户密码 mc admin user update myminio reports newpassword123 # 生成临时访问密钥 mc admin user svcacct add <alias> <username> # 示例:为reports用户创建服务账户 mc admin user svcacct add myminio reports高级用户配置# 创建带策略的新用户(一步完成) mc admin user add <alias> <username> <password> --policy-name=<policy> # 示例:创建带writeonly策略的用户 mc admin user add myminio uploader upload123 --policy-name=writeonly # 设置用户描述信息 mc admin user update <alias> <username> --description="User description" # 示例:设置用户描述 mc admin user update myminio reports --description="Monthly reports generator"用户管理实际使用案例# 1. 创建管理员用户 mc admin user add myminio admin admin123 mc admin policy attach myminio consoleAdmin --user=admin # 2. 创建只读用户 mc admin user add myminio viewer view123 mc admin policy attach myminio readonly --user=viewer # 3. 创建特定存储桶权限用户 # 先创建自定义策略文件bucket-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": ["s3:GetObject"], "Resource": ["arn:aws:s3:::reports-bucket/*"] } ] } # 添加策略 mc admin policy create myminio reports-reader bucket-policy.json # 创建用户并附加策略 mc admin user add myminio report-reader reader123 mc admin policy attach myminio reports-reader --user=report-reader配置同步mc mirror -w old new

minio命令 客户端配置# 配置别名(连接远程MinIO服务器) mc alias set myminio http://localhost:9000 ACCESS_KEY SECRET_KEY # 示例: mc alias set myminio http://127.0.0.1:9000 username password # 列出所有配置的别名 mc alias list存储桶操作# 创建存储桶 mc mb myminio/mybucket # 列出所有存储桶 mc ls myminio # 删除空存储桶 mc rb myminio/mybucket # 强制删除非空存储桶 mc rb --force myminio/mybucket对象操作# 上传文件 mc cp localfile.txt myminio/mybucket/ # 下载文件 mc cp myminio/mybucket/remotefile.txt . # 列出存储桶内容 mc ls myminio/mybucket # 删除对象 mc rm myminio/mybucket/file.txt # 递归删除目录 mc rm --recursive myminio/mybucket/mydir策略管理# 设置存储桶为公开可读 mc anonymous set download myminio/mybucket # 设置存储桶为私有 mc anonymous set none myminio/mybucket # 添加用户 mc admin user add myminio newuser newpassword # 设置用户策略 mc admin policy set myminio readwrite user=newuser监控与维护# 查看服务器信息 mc admin info myminio # 查看服务健康状态 mc admin heal myminio # 查看存储桶使用情况 mc du myminio/mybucket高级功能# 设置对象保留策略 mc retention set --default GOVERNANCE 30d myminio/mybucket # 设置对象锁定(合规模式) mc retention set --default COMPLIANCE 30d myminio/mybucket # 启用版本控制 mc version enable myminio/mybucket # 列出对象版本 mc ls --versions myminio/mybucket管理用户mc admin user # 创建用户 mc admin user add <alias> <username> <password> # 示例:创建名为reports的用户 mc admin user add myminio reports user123456 # 列出所有用户 mc admin user list <alias> # 示例:列出myminio的所有用户 mc admin user list myminio # 查看用户信息 mc admin user info <alias> <username> # 示例:查看reports用户信息 mc admin user info myminio reports # 禁用用户 mc admin user disable <alias> <username> # 示例:禁用reports用户 mc admin user disable myminio reports # 启用用户 mc admin user enable <alias> <username> # 示例:重新启用reports用户 mc admin user enable myminio reports # 删除用户 mc admin user remove <alias> <username> # 示例:删除reports用户 mc admin user remove myminio reports用户策略管理# 为用户分配策略 mc admin policy attach <alias> <policy-name> --user=<username> # 示例:为reports用户分配readonly策略 mc admin policy attach myminio readonly --user=reports # 查看用户当前策略 mc admin policy info <alias> --user=<username> # 示例:查看reports用户的策略 mc admin policy info myminio --user=reports # 解除用户策略 mc admin policy detach <alias> <policy-name> --user=<username> # 示例:移除reports用户的readonly策略 mc admin policy detach myminio readonly --user=reports用户密钥管理# 修改用户密码 mc admin user update <alias> <username> <new-password> # 示例:修改reports用户密码 mc admin user update myminio reports newpassword123 # 生成临时访问密钥 mc admin user svcacct add <alias> <username> # 示例:为reports用户创建服务账户 mc admin user svcacct add myminio reports高级用户配置# 创建带策略的新用户(一步完成) mc admin user add <alias> <username> <password> --policy-name=<policy> # 示例:创建带writeonly策略的用户 mc admin user add myminio uploader upload123 --policy-name=writeonly # 设置用户描述信息 mc admin user update <alias> <username> --description="User description" # 示例:设置用户描述 mc admin user update myminio reports --description="Monthly reports generator"用户管理实际使用案例# 1. 创建管理员用户 mc admin user add myminio admin admin123 mc admin policy attach myminio consoleAdmin --user=admin # 2. 创建只读用户 mc admin user add myminio viewer view123 mc admin policy attach myminio readonly --user=viewer # 3. 创建特定存储桶权限用户 # 先创建自定义策略文件bucket-policy.json { "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Action": ["s3:GetObject"], "Resource": ["arn:aws:s3:::reports-bucket/*"] } ] } # 添加策略 mc admin policy create myminio reports-reader bucket-policy.json # 创建用户并附加策略 mc admin user add myminio report-reader reader123 mc admin policy attach myminio reports-reader --user=report-reader配置同步mc mirror -w old new -

-

docker安装lucky 1. 使用docker-compose安装luckyservices: lucky: image: gdy666/lucky:latest network_mode: host restart: always volumes: - ./data:/goodluck2. 安装后,使用ddns通过指令获取ipv6curl 6.ipw.cn这时候发现没有curl命令,通过下面的方法,给容器安装curl# 在宿主机操作 wget https://github.com/moparisthebest/static-curl/releases/download/v8.4.0/curl-amd64 -O curl-static chmod +x curl-static docker cp curl-static 容器名:/usr/bin/curl docker exec 容器名 curl --version

docker安装lucky 1. 使用docker-compose安装luckyservices: lucky: image: gdy666/lucky:latest network_mode: host restart: always volumes: - ./data:/goodluck2. 安装后,使用ddns通过指令获取ipv6curl 6.ipw.cn这时候发现没有curl命令,通过下面的方法,给容器安装curl# 在宿主机操作 wget https://github.com/moparisthebest/static-curl/releases/download/v8.4.0/curl-amd64 -O curl-static chmod +x curl-static docker cp curl-static 容器名:/usr/bin/curl docker exec 容器名 curl --version -

python库 faker faker,一个非常厉害的 Python 库Github地址:https://github.com/joke2k/faker在软件开发和测试过程中,生成真实可信的测试数据是一项重要但耗时的工作。Python的faker库提供了一个简单而强大的解决方案,它能够生成各种类型的虚拟数据,包括个人信息、地址、公司信息等。这些数据看起来十分真实,非常适合用于开发测试、数据库填充和应用程序演示。安装基础安装使用pip包管理器进行安装:pip install faker基本功能生成个人信息faker库提供了丰富的个人信息生成功能,包括姓名、地址、电话号码等。这些数据可以按照不同的语言和地区格式生成,确保了数据的本地化和真实性。from faker import Faker # 创建Faker实例 fake = Faker('zh_CN') # 使用中文本地化 # 生成个人基本信息 print(f"姓名: {fake.name()}") print(f"地址: {fake.address()}") print(f"手机号: {fake.phone_number()}") print(f"电子邮箱: {fake.email()}") print(f"身份证号: {fake.ssn()}")生成公司信息在企业应用开发中,经常需要模拟公司相关的信息。faker提供了完整的公司信息生成功能,包括公司名称、职位名称、营业执照号等数据。from faker import Faker fake = Faker('zh_CN') # 生成公司相关信息 print(f"公司名称: {fake.company()}") print(f"职位名称: {fake.job()}") print(f"公司口号: {fake.catch_phrase()}") print(f"营业执照号: {fake.company_prefix()}") print(f"公司地址: {fake.company_suffix()}")生成日期和时间faker支持生成各种格式的日期和时间数据,可以指定日期范围,生成过去或未来的随机时间。这对于创建时间序列数据或测试日期相关功能特别有用。from faker import Faker from datetime import datetime, timedelta fake = Faker() # 生成日期时间数据 print(f"当前时间: {fake.date_time_this_month()}") print(f"过去日期: {fake.date_time_between(start_date='-30d', end_date='now')}") print(f"未来日期: {fake.future_date(end_date='+30d')}") print(f"时间戳: {fake.unix_time()}")高级功能自定义数据生成器faker允许创建自定义的数据生成器,可以根据特定需求定义数据的生成规则。这种灵活性使其能够适应各种特殊的数据生成需求。from faker import Faker from faker.providers import BaseProvider class CustomProvider(BaseProvider): def custom_product_code(self): return f"PRD-{self.random_int(min=1000, max=9999)}" def custom_status(self): statuses = ['待处理', '处理中', '已完成', '已取消'] return self.random_element(statuses) fake = Faker('zh_CN') fake.add_provider(CustomProvider) # 使用自定义生成器 print(f"产品编码: {fake.custom_product_code()}") print(f"订单状态: {fake.custom_status()}")多语言支持faker提供了出色的多语言支持,可以根据不同地区的特点生成本地化数据。这对于开发国际化应用或测试多语言功能非常有帮助。from faker import Faker # 创建多语言Faker实例 fake_cn = Faker('zh_CN') # 中文 fake_en = Faker('en_US') # 英文 fake_jp = Faker('ja_JP') # 日文 # 生成不同语言的数据 print("中文姓名:", fake_cn.name()) print("英文姓名:", fake_en.name()) print("日文姓名:", fake_jp.name()) print("中文地址:", fake_cn.address()) print("英文地址:", fake_en.address()) print("日文地址:", fake_jp.address())实际应用场景数据库测试数据生成在开发过程中,经常需要生成大量测试数据来填充数据库。使用faker可以快速生成符合要求的测试数据,帮助开发人员进行功能测试和性能测试。from faker import Faker import sqlite3 class TestDataGenerator: def __init__(self): self.fake = Faker('zh_CN') self.conn = sqlite3.connect('test.db') self.cursor = self.conn.cursor() def create_tables(self): self.cursor.execute(''' CREATE TABLE IF NOT EXISTS users ( id INTEGER PRIMARY KEY, name TEXT, email TEXT, address TEXT, phone TEXT ) ''') def generate_user_data(self, count): for _ in range(count): self.cursor.execute(''' INSERT INTO users (name, email, address, phone) VALUES (?, ?, ?, ?) ''', ( self.fake.name(), self.fake.email(), self.fake.address(), self.fake.phone_number() )) self.conn.commit() # 使用示例 generator = TestDataGenerator() generator.create_tables() generator.generate_user_data(100)API测试数据模拟在进行API测试时,需要模拟各种请求数据。faker可以帮助生成符合API要求的测试数据,提高测试效率和覆盖率。from faker import Faker import json class APITestDataGenerator: def __init__(self): self.fake = Faker('zh_CN') def generate_user_payload(self): return { "user": { "name": self.fake.name(), "email": self.fake.email(), "phone": self.fake.phone_number(), "address": { "street": self.fake.street_address(), "city": self.fake.city(), "postcode": self.fake.postcode() } } } def generate_order_payload(self): return { "order": { "order_id": self.fake.uuid4(), "customer_name": self.fake.name(), "product_name": self.fake.word(), "quantity": self.fake.random_int(min=1, max=10), "order_date": self.fake.date_time_this_month().isoformat() } } # 使用示例 generator = APITestDataGenerator() user_data = generator.generate_user_payload() order_data = generator.generate_order_payload() print(json.dumps(user_data, indent=2, ensure_ascii=False)) print(json.dumps(order_data, indent=2, ensure_ascii=False))总结Python faker库为开发者提供了一个强大而灵活的测试数据生成解决方案。通过其丰富的内置数据生成器和自定义功能,开发者可以轻松创建各种类型的模拟数据。faker的多语言支持和本地化特性使其特别适合国际化应用的开发和测试。在实际应用中,从简单的个人信息生成到复杂的数据库测试数据填充,faker都展现出了优秀的性能和可靠性。

python库 faker faker,一个非常厉害的 Python 库Github地址:https://github.com/joke2k/faker在软件开发和测试过程中,生成真实可信的测试数据是一项重要但耗时的工作。Python的faker库提供了一个简单而强大的解决方案,它能够生成各种类型的虚拟数据,包括个人信息、地址、公司信息等。这些数据看起来十分真实,非常适合用于开发测试、数据库填充和应用程序演示。安装基础安装使用pip包管理器进行安装:pip install faker基本功能生成个人信息faker库提供了丰富的个人信息生成功能,包括姓名、地址、电话号码等。这些数据可以按照不同的语言和地区格式生成,确保了数据的本地化和真实性。from faker import Faker # 创建Faker实例 fake = Faker('zh_CN') # 使用中文本地化 # 生成个人基本信息 print(f"姓名: {fake.name()}") print(f"地址: {fake.address()}") print(f"手机号: {fake.phone_number()}") print(f"电子邮箱: {fake.email()}") print(f"身份证号: {fake.ssn()}")生成公司信息在企业应用开发中,经常需要模拟公司相关的信息。faker提供了完整的公司信息生成功能,包括公司名称、职位名称、营业执照号等数据。from faker import Faker fake = Faker('zh_CN') # 生成公司相关信息 print(f"公司名称: {fake.company()}") print(f"职位名称: {fake.job()}") print(f"公司口号: {fake.catch_phrase()}") print(f"营业执照号: {fake.company_prefix()}") print(f"公司地址: {fake.company_suffix()}")生成日期和时间faker支持生成各种格式的日期和时间数据,可以指定日期范围,生成过去或未来的随机时间。这对于创建时间序列数据或测试日期相关功能特别有用。from faker import Faker from datetime import datetime, timedelta fake = Faker() # 生成日期时间数据 print(f"当前时间: {fake.date_time_this_month()}") print(f"过去日期: {fake.date_time_between(start_date='-30d', end_date='now')}") print(f"未来日期: {fake.future_date(end_date='+30d')}") print(f"时间戳: {fake.unix_time()}")高级功能自定义数据生成器faker允许创建自定义的数据生成器,可以根据特定需求定义数据的生成规则。这种灵活性使其能够适应各种特殊的数据生成需求。from faker import Faker from faker.providers import BaseProvider class CustomProvider(BaseProvider): def custom_product_code(self): return f"PRD-{self.random_int(min=1000, max=9999)}" def custom_status(self): statuses = ['待处理', '处理中', '已完成', '已取消'] return self.random_element(statuses) fake = Faker('zh_CN') fake.add_provider(CustomProvider) # 使用自定义生成器 print(f"产品编码: {fake.custom_product_code()}") print(f"订单状态: {fake.custom_status()}")多语言支持faker提供了出色的多语言支持,可以根据不同地区的特点生成本地化数据。这对于开发国际化应用或测试多语言功能非常有帮助。from faker import Faker # 创建多语言Faker实例 fake_cn = Faker('zh_CN') # 中文 fake_en = Faker('en_US') # 英文 fake_jp = Faker('ja_JP') # 日文 # 生成不同语言的数据 print("中文姓名:", fake_cn.name()) print("英文姓名:", fake_en.name()) print("日文姓名:", fake_jp.name()) print("中文地址:", fake_cn.address()) print("英文地址:", fake_en.address()) print("日文地址:", fake_jp.address())实际应用场景数据库测试数据生成在开发过程中,经常需要生成大量测试数据来填充数据库。使用faker可以快速生成符合要求的测试数据,帮助开发人员进行功能测试和性能测试。from faker import Faker import sqlite3 class TestDataGenerator: def __init__(self): self.fake = Faker('zh_CN') self.conn = sqlite3.connect('test.db') self.cursor = self.conn.cursor() def create_tables(self): self.cursor.execute(''' CREATE TABLE IF NOT EXISTS users ( id INTEGER PRIMARY KEY, name TEXT, email TEXT, address TEXT, phone TEXT ) ''') def generate_user_data(self, count): for _ in range(count): self.cursor.execute(''' INSERT INTO users (name, email, address, phone) VALUES (?, ?, ?, ?) ''', ( self.fake.name(), self.fake.email(), self.fake.address(), self.fake.phone_number() )) self.conn.commit() # 使用示例 generator = TestDataGenerator() generator.create_tables() generator.generate_user_data(100)API测试数据模拟在进行API测试时,需要模拟各种请求数据。faker可以帮助生成符合API要求的测试数据,提高测试效率和覆盖率。from faker import Faker import json class APITestDataGenerator: def __init__(self): self.fake = Faker('zh_CN') def generate_user_payload(self): return { "user": { "name": self.fake.name(), "email": self.fake.email(), "phone": self.fake.phone_number(), "address": { "street": self.fake.street_address(), "city": self.fake.city(), "postcode": self.fake.postcode() } } } def generate_order_payload(self): return { "order": { "order_id": self.fake.uuid4(), "customer_name": self.fake.name(), "product_name": self.fake.word(), "quantity": self.fake.random_int(min=1, max=10), "order_date": self.fake.date_time_this_month().isoformat() } } # 使用示例 generator = APITestDataGenerator() user_data = generator.generate_user_payload() order_data = generator.generate_order_payload() print(json.dumps(user_data, indent=2, ensure_ascii=False)) print(json.dumps(order_data, indent=2, ensure_ascii=False))总结Python faker库为开发者提供了一个强大而灵活的测试数据生成解决方案。通过其丰富的内置数据生成器和自定义功能,开发者可以轻松创建各种类型的模拟数据。faker的多语言支持和本地化特性使其特别适合国际化应用的开发和测试。在实际应用中,从简单的个人信息生成到复杂的数据库测试数据填充,faker都展现出了优秀的性能和可靠性。 -

Python异步任务调度:任务队列Celery Python异步任务调度:最牛逼的任务队列神器Celery在现代应用中,异步任务调度无疑是提升性能和响应速度的关键之一。尤其在处理高并发、长时间运行任务时,如何让后台任务异步执行成为了开发者面临的一个重要问题。Python中,Celery 是一个强大且广泛使用的异步任务队列工具,它让你可以轻松处理并发任务、定时任务以及任务调度。那么,今天我们就来深入了解Celery以及如何在Python项目中使用它。什么是Celery?Celery 是一个分布式的任务队列系统,支持异步任务执行和定时任务调度。通过Celery,你可以把一些耗时的操作,比如发送邮件、视频处理、图像处理等从主流程中提取出来,交给Celery去处理,这样就能有效提升系统的响应速度和用户体验。Celery通常与消息代理(如RabbitMQ或Redis)结合使用,负责将任务分配给多个工作进程进行异步执行。它的工作原理就像是一个生产者-消费者模式,生产者将任务放入队列,消费者从队列中取出任务并执行。安装Celery首先,我们需要安装Celery。你可以通过pip命令轻松安装:pip install celery使用Celery调度任务让我们通过一个简单的例子来了解如何使用Celery调度异步任务。假设你正在开发一个网站,并且想要在用户注册后发送一个欢迎邮件,而发送邮件是一个耗时操作。为了避免阻塞用户注册的流程,我们希望将邮件发送任务放到Celery中异步执行。步骤1:创建一个Celery实例首先,我们需要创建一个Celery应用。我们可以将其配置成在一个叫做celery.py的文件中:from celery import Celery # 创建一个Celery实例,配置消息队列为Redis app = Celery('tasks', broker='redis://localhost:6379/0') # 定义任务 @app.task def send_welcome_email(user_email): print(f"Sending welcome email to {user_email}") # 这里可以调用发送邮件的逻辑 return f"Email sent to {user_email}"在上面的代码中:Celery('tasks', broker='redis://localhost:6379/0')这一行代码创建了一个Celery应用,并指定了消息代理使用Redis。send_welcome_email是我们定义的一个简单任务,它会模拟发送邮件。步骤2:启动Celery Worker在开发过程中,你可以启动Celery Worker来处理任务。进入项目根目录,执行以下命令:celery -A celery worker --loglevel=info这个命令会启动Celery的工作进程(worker)。它会从消息队列中取出任务并执行。你会看到类似以下的输出,表示Celery Worker已经准备好接收任务了。[2025-02-14 15:00:00,000: INFO/MainProcess] Connected to redis://localhost:6379/0 [2025-02-14 15:00:01,000: INFO/MainProcess] mingle: searching for neighbors [2025-02-14 15:00:02,000: INFO/MainProcess] mingle: all alone [2025-02-14 15:00:02,000: INFO/MainProcess] celery@hostname ready.步骤3:调用任务接下来,我们可以通过Python脚本来调用这个异步任务:from celery import Celery from tasks import send_welcome_email # 调用异步任务 send_welcome_email.delay('user@example.com')send_welcome_email.delay('user@example.com') 是Celery提供的一个异步调用方法,使用delay方法将任务提交到队列中,而不是直接执行。这时,Celery Worker会从队列中取出任务并执行。当邮件发送完成后,你会看到终端输出了类似:Sending welcome email to user@example.com定时任务调度除了异步任务,Celery 还支持定时任务调度,类似于Linux的cron任务。我们可以利用celery-beat扩展来实现定时任务。让我们来写个简单的定时任务,比如每小时检查一次用户的邮箱是否有效。步骤1:安装celery-beatpip install celery[redis] celery[redis]==5.0.5 pip install celery[beat]步骤2:配置定时任务在celery.py中添加如下配置:from celery import Celery from celery.schedules import crontab app = Celery('tasks', broker='redis://localhost:6379/0') @app.task def check_email_validity(): print("Checking email validity for users...") # 定义定时任务,每小时执行一次 app.conf.beat_schedule = { 'check-email-validity-every-hour': { 'task': 'tasks.check_email_validity', 'schedule': crontab(minute=0, hour='*'), # 每小时的第0分钟执行 }, }步骤3:启动Celery Beat除了启动Worker,我们还需要启动Celery Beat来调度定时任务:celery -A celery beat --loglevel=info这时,check_email_validity任务会每小时自动执行一次。总结Celery是一个非常强大的Python任务队列工具,适合用于处理异步任务和定时任务。在开发现代应用时,Celery帮助我们将耗时任务从主流程中分离出来,从而提升系统性能和响应速度。通过简单的配置和几行代码,你就能在项目中轻松集成Celery,实现异步执行任务和定时任务调度。无论你是开发Web应用、后台任务还是周期性调度任务,Celery都能成为你最牛逼的得力助手!

Python异步任务调度:任务队列Celery Python异步任务调度:最牛逼的任务队列神器Celery在现代应用中,异步任务调度无疑是提升性能和响应速度的关键之一。尤其在处理高并发、长时间运行任务时,如何让后台任务异步执行成为了开发者面临的一个重要问题。Python中,Celery 是一个强大且广泛使用的异步任务队列工具,它让你可以轻松处理并发任务、定时任务以及任务调度。那么,今天我们就来深入了解Celery以及如何在Python项目中使用它。什么是Celery?Celery 是一个分布式的任务队列系统,支持异步任务执行和定时任务调度。通过Celery,你可以把一些耗时的操作,比如发送邮件、视频处理、图像处理等从主流程中提取出来,交给Celery去处理,这样就能有效提升系统的响应速度和用户体验。Celery通常与消息代理(如RabbitMQ或Redis)结合使用,负责将任务分配给多个工作进程进行异步执行。它的工作原理就像是一个生产者-消费者模式,生产者将任务放入队列,消费者从队列中取出任务并执行。安装Celery首先,我们需要安装Celery。你可以通过pip命令轻松安装:pip install celery使用Celery调度任务让我们通过一个简单的例子来了解如何使用Celery调度异步任务。假设你正在开发一个网站,并且想要在用户注册后发送一个欢迎邮件,而发送邮件是一个耗时操作。为了避免阻塞用户注册的流程,我们希望将邮件发送任务放到Celery中异步执行。步骤1:创建一个Celery实例首先,我们需要创建一个Celery应用。我们可以将其配置成在一个叫做celery.py的文件中:from celery import Celery # 创建一个Celery实例,配置消息队列为Redis app = Celery('tasks', broker='redis://localhost:6379/0') # 定义任务 @app.task def send_welcome_email(user_email): print(f"Sending welcome email to {user_email}") # 这里可以调用发送邮件的逻辑 return f"Email sent to {user_email}"在上面的代码中:Celery('tasks', broker='redis://localhost:6379/0')这一行代码创建了一个Celery应用,并指定了消息代理使用Redis。send_welcome_email是我们定义的一个简单任务,它会模拟发送邮件。步骤2:启动Celery Worker在开发过程中,你可以启动Celery Worker来处理任务。进入项目根目录,执行以下命令:celery -A celery worker --loglevel=info这个命令会启动Celery的工作进程(worker)。它会从消息队列中取出任务并执行。你会看到类似以下的输出,表示Celery Worker已经准备好接收任务了。[2025-02-14 15:00:00,000: INFO/MainProcess] Connected to redis://localhost:6379/0 [2025-02-14 15:00:01,000: INFO/MainProcess] mingle: searching for neighbors [2025-02-14 15:00:02,000: INFO/MainProcess] mingle: all alone [2025-02-14 15:00:02,000: INFO/MainProcess] celery@hostname ready.步骤3:调用任务接下来,我们可以通过Python脚本来调用这个异步任务:from celery import Celery from tasks import send_welcome_email # 调用异步任务 send_welcome_email.delay('user@example.com')send_welcome_email.delay('user@example.com') 是Celery提供的一个异步调用方法,使用delay方法将任务提交到队列中,而不是直接执行。这时,Celery Worker会从队列中取出任务并执行。当邮件发送完成后,你会看到终端输出了类似:Sending welcome email to user@example.com定时任务调度除了异步任务,Celery 还支持定时任务调度,类似于Linux的cron任务。我们可以利用celery-beat扩展来实现定时任务。让我们来写个简单的定时任务,比如每小时检查一次用户的邮箱是否有效。步骤1:安装celery-beatpip install celery[redis] celery[redis]==5.0.5 pip install celery[beat]步骤2:配置定时任务在celery.py中添加如下配置:from celery import Celery from celery.schedules import crontab app = Celery('tasks', broker='redis://localhost:6379/0') @app.task def check_email_validity(): print("Checking email validity for users...") # 定义定时任务,每小时执行一次 app.conf.beat_schedule = { 'check-email-validity-every-hour': { 'task': 'tasks.check_email_validity', 'schedule': crontab(minute=0, hour='*'), # 每小时的第0分钟执行 }, }步骤3:启动Celery Beat除了启动Worker,我们还需要启动Celery Beat来调度定时任务:celery -A celery beat --loglevel=info这时,check_email_validity任务会每小时自动执行一次。总结Celery是一个非常强大的Python任务队列工具,适合用于处理异步任务和定时任务。在开发现代应用时,Celery帮助我们将耗时任务从主流程中分离出来,从而提升系统性能和响应速度。通过简单的配置和几行代码,你就能在项目中轻松集成Celery,实现异步执行任务和定时任务调度。无论你是开发Web应用、后台任务还是周期性调度任务,Celery都能成为你最牛逼的得力助手! -

python网络编程:ZeroMQ实战指南 想写分布式应用却被Socket编程折腾得够呛?今天给大家介绍一个超强的网络通信库:ZeroMQ(也叫ØMQ)。它不仅简单易用,性能还贼棒!让我们一起来玩转这个神器!1. 为什么选ZeroMQ?传统Socket编程就像用电报机发消息:又慢又容易出错。而ZeroMQ就像用微信聊天:简单、快速、可靠。它能帮你:轻松实现进程间通信搞定分布式系统处理高并发场景2. 快速入门先安装ZeroMQ的Python绑定:pip install pyzmq2.1 最简单的例子:请求-响应模式服务端代码(server.py):import zmq import time context = zmq.Context() socket = context.socket(zmq.REP) socket.bind("tcp://*:5555") print("服务器已启动,等待客户端连接...") while True: # 等待客户端请求 message = socket.recv_string() print(f"收到请求: {message}") # 模拟处理时间 time.sleep(1) # 发送响应 response = f"收到你的消息:{message}" socket.send_string(response)客户端代码(client.py):import zmq context = zmq.Context() socket = context.socket(zmq.REQ) socket.connect("tcp://localhost:5555") for i in range(3): message = f"Hello {i}" print(f"发送请求: {message}") # 发送请求 socket.send_string(message) # 等待响应 response = socket.recv_string() print(f"收到响应: {response}\n")是不是超简单?运行效果就像微信对话一样:发消息→等回复→收到回复。3. 进阶应用:发布-订阅模式这个模式特别适合做消息推送,比如气象站向多个用户推送天气数据。发布者代码(publisher.py):import zmq import time import random def weather_update(): return { "温度": round(random.uniform(20, 30), 1), "湿度": round(random.uniform(40, 70), 1) } context = zmq.Context() socket = context.socket(zmq.PUB) socket.bind("tcp://*:5556") print("气象站启动...") while True: data = weather_update() message = f"北京,{data['温度']},{data['湿度']}" socket.send_string(message) print(f"发布天气数据: {message}") time.sleep(2)订阅者代码(subscriber.py):import zmq context = zmq.Context() socket = context.socket(zmq.SUB) socket.connect("tcp://localhost:5556") socket.setsockopt_string(zmq.SUBSCRIBE, "北京") print("天气监测站已连接,等待数据...") while True: message = socket.recv_string() city, temp, humidity = message.split(',') print(f"\n{city}实时天气:") print(f"温度: {temp}°C") print(f"湿度: {humidity}%")4. 实战项目:简单的分布式计算系统来个实用的例子:主节点分发任务,工作节点处理任务。任务分发器(dispatcher.py):import zmq import random import time context = zmq.Context() sender = context.socket(zmq.PUSH) sender.bind("tcp://*:5557") collector = context.socket(zmq.PULL) collector.bind("tcp://*:5558") print("任务分发系统启动...") # 发送任务 tasks_sent = 0 while tasks_sent < 10: # 创建一个计算任务 data = random.randint(1, 100) sender.send_json({ "task_id": tasks_sent, "data": data }) print(f"发送任务 {tasks_sent}: 计算{data}的平方") tasks_sent += 1 # 接收结果 results = [] while len(results) < 10: result = collector.recv_json() results.append(result) print(f"收到任务{result['task_id']}的结果: {result['result']}") print("\n所有任务完成!")工作节点(worker.py):import zmq import time import random context = zmq.Context() receiver = context.socket(zmq.PULL) receiver.connect("tcp://localhost:5557") sender = context.socket(zmq.PUSH) sender.connect("tcp://localhost:5558") print("工作节点已启动,等待任务...") while True: task = receiver.recv_json() # 模拟计算过程 time.sleep(random.random()) # 计算结果 result = task['data'] ** 2 # 发送结果 sender.send_json({ "task_id": task['task_id'], "result": result }) print(f"完成任务{task['task_id']}: {task['data']}的平方是{result}")5. 实用技巧5.1 消息模式选择指南REQ/REP:适合客户端-服务器模型PUB/SUB:适合数据广播场景PUSH/PULL:适合任务分发场景5.2 错误处理import zmq import zmq.error try: socket.send_string("消息", zmq.NOBLOCK) except zmq.error.Again: print("发送缓冲区已满,消息未发送")5.3 超时处理import zmq from zmq.error import Again poller = zmq.Poller() poller.register(socket, zmq.POLLIN) # 等待1秒 if poller.poll(1000): message = socket.recv_string() else: print("接收超时")6. 性能优化小贴士使用合适的消息大小:太小:网络开销占比大太大:延迟增加建议:1KB到1MB之间适当的缓冲区设置:socket.setsockopt(zmq.SNDHWM, 1000) # 发送缓冲区大小 socket.setsockopt(zmq.RCVHWM, 1000) # 接收缓冲区大小使用多线程提升性能:from threading import Thread def worker(): context = zmq.Context() socket = context.socket(zmq.REP) socket.connect("inproc://workers") # 处理逻辑... threads = [Thread(target=worker) for _ in range(3)] for thread in threads: thread.start()ZeroMQ就像是给程序装上了"微信":简单:几行代码搞定通信灵活:多种通信模式随意选可靠:自动重连、消息队列高效:性能甩开传统Socket几条街掌握了ZeroMQ,分布式系统不再是噩梦!

python网络编程:ZeroMQ实战指南 想写分布式应用却被Socket编程折腾得够呛?今天给大家介绍一个超强的网络通信库:ZeroMQ(也叫ØMQ)。它不仅简单易用,性能还贼棒!让我们一起来玩转这个神器!1. 为什么选ZeroMQ?传统Socket编程就像用电报机发消息:又慢又容易出错。而ZeroMQ就像用微信聊天:简单、快速、可靠。它能帮你:轻松实现进程间通信搞定分布式系统处理高并发场景2. 快速入门先安装ZeroMQ的Python绑定:pip install pyzmq2.1 最简单的例子:请求-响应模式服务端代码(server.py):import zmq import time context = zmq.Context() socket = context.socket(zmq.REP) socket.bind("tcp://*:5555") print("服务器已启动,等待客户端连接...") while True: # 等待客户端请求 message = socket.recv_string() print(f"收到请求: {message}") # 模拟处理时间 time.sleep(1) # 发送响应 response = f"收到你的消息:{message}" socket.send_string(response)客户端代码(client.py):import zmq context = zmq.Context() socket = context.socket(zmq.REQ) socket.connect("tcp://localhost:5555") for i in range(3): message = f"Hello {i}" print(f"发送请求: {message}") # 发送请求 socket.send_string(message) # 等待响应 response = socket.recv_string() print(f"收到响应: {response}\n")是不是超简单?运行效果就像微信对话一样:发消息→等回复→收到回复。3. 进阶应用:发布-订阅模式这个模式特别适合做消息推送,比如气象站向多个用户推送天气数据。发布者代码(publisher.py):import zmq import time import random def weather_update(): return { "温度": round(random.uniform(20, 30), 1), "湿度": round(random.uniform(40, 70), 1) } context = zmq.Context() socket = context.socket(zmq.PUB) socket.bind("tcp://*:5556") print("气象站启动...") while True: data = weather_update() message = f"北京,{data['温度']},{data['湿度']}" socket.send_string(message) print(f"发布天气数据: {message}") time.sleep(2)订阅者代码(subscriber.py):import zmq context = zmq.Context() socket = context.socket(zmq.SUB) socket.connect("tcp://localhost:5556") socket.setsockopt_string(zmq.SUBSCRIBE, "北京") print("天气监测站已连接,等待数据...") while True: message = socket.recv_string() city, temp, humidity = message.split(',') print(f"\n{city}实时天气:") print(f"温度: {temp}°C") print(f"湿度: {humidity}%")4. 实战项目:简单的分布式计算系统来个实用的例子:主节点分发任务,工作节点处理任务。任务分发器(dispatcher.py):import zmq import random import time context = zmq.Context() sender = context.socket(zmq.PUSH) sender.bind("tcp://*:5557") collector = context.socket(zmq.PULL) collector.bind("tcp://*:5558") print("任务分发系统启动...") # 发送任务 tasks_sent = 0 while tasks_sent < 10: # 创建一个计算任务 data = random.randint(1, 100) sender.send_json({ "task_id": tasks_sent, "data": data }) print(f"发送任务 {tasks_sent}: 计算{data}的平方") tasks_sent += 1 # 接收结果 results = [] while len(results) < 10: result = collector.recv_json() results.append(result) print(f"收到任务{result['task_id']}的结果: {result['result']}") print("\n所有任务完成!")工作节点(worker.py):import zmq import time import random context = zmq.Context() receiver = context.socket(zmq.PULL) receiver.connect("tcp://localhost:5557") sender = context.socket(zmq.PUSH) sender.connect("tcp://localhost:5558") print("工作节点已启动,等待任务...") while True: task = receiver.recv_json() # 模拟计算过程 time.sleep(random.random()) # 计算结果 result = task['data'] ** 2 # 发送结果 sender.send_json({ "task_id": task['task_id'], "result": result }) print(f"完成任务{task['task_id']}: {task['data']}的平方是{result}")5. 实用技巧5.1 消息模式选择指南REQ/REP:适合客户端-服务器模型PUB/SUB:适合数据广播场景PUSH/PULL:适合任务分发场景5.2 错误处理import zmq import zmq.error try: socket.send_string("消息", zmq.NOBLOCK) except zmq.error.Again: print("发送缓冲区已满,消息未发送")5.3 超时处理import zmq from zmq.error import Again poller = zmq.Poller() poller.register(socket, zmq.POLLIN) # 等待1秒 if poller.poll(1000): message = socket.recv_string() else: print("接收超时")6. 性能优化小贴士使用合适的消息大小:太小:网络开销占比大太大:延迟增加建议:1KB到1MB之间适当的缓冲区设置:socket.setsockopt(zmq.SNDHWM, 1000) # 发送缓冲区大小 socket.setsockopt(zmq.RCVHWM, 1000) # 接收缓冲区大小使用多线程提升性能:from threading import Thread def worker(): context = zmq.Context() socket = context.socket(zmq.REP) socket.connect("inproc://workers") # 处理逻辑... threads = [Thread(target=worker) for _ in range(3)] for thread in threads: thread.start()ZeroMQ就像是给程序装上了"微信":简单:几行代码搞定通信灵活:多种通信模式随意选可靠:自动重连、消息队列高效:性能甩开传统Socket几条街掌握了ZeroMQ,分布式系统不再是噩梦! -

dify和ollama使用教程 1. 安装docker这一步百度2. 安装difygit clone https://github.com/langgenius/dify.git cd dify cd docker cp .env.example .env docker-compose up -denv里面可以修改映射的端口,默认是80和443,教程先默认{callout color="#f0ad4e"}EXPOSE_NGINX_PORT=4080EXPOSE_NGINX_SSL_PORT=4443{/callout}2.1 之后访问 localhost/install 进行安装3. 安装Ollama然后我们需要去安装Ollama,官网地址https://ollama.com/安装完ollama后去找适合的模型下载https://ollama.com/search下列我举例一下网友比较推荐的模型{callout color="#e1e1db"}yi Yi 1.5 是一个高性能的双语语言模型。 参数大小:6b9b34b 更新时间:7个月前 适合编程的双语(中文和英文)模型。yi-coder Yi-Coder 是一系列开源代码语言模型,提供少于100亿参数的最先进的编码性能。 参数大小:1.5b9b 更新时间:3个月前 适合编程的双语模型。qwen Qwen 1.5 是由阿里云提供的一系列大型语言模型,参数从0.5B到110B不等。 参数大小:0.5b1.8b4b7b14b32b72b110b 更新时间:8个月前 阿里云提供的模型,可能包含对中文的支持。 qwen2 Qwen2 是阿里集团提供的一系列大型语言模型。 参数大小:tools0.5b1.5b7b72b 更新时间:3个月前 同样可能包含对中文的支持。llama2-chinese Llama 2 基于模型,针对提高中文对话能力进行了微调。 参数大小:7b13b 更新时间:14个月前 专门针对中文对话进行了优化的模型。{/callout}这里的几b是代表着多少亿的参数,个人笔记本建议选择10b以内,不然参数太多了可能会很慢。这里我以yi-coder为例子终端运行ollama run yi-coderollama run yi-coder pulling manifestpulling 8169bd33ad13... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 5.0 GB pulling afc128547699... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 527 B pulling 43070e2d4e53... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 11 KB pulling 3dc12ee097e8... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 135 B pulling a60ed831ae4c... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 485 B verifying sha256 digest writing manifest success >>> 你好Hi, how can I assist you? Please provide more specific information about your request.4.然后dify里面配置模型这里URL填写http://host.docker.internal:11434(因为dify是安装在docker里面的,但是ollama是安装在本机的,所以需要让docker访问ollama的api)点击保存,右上角会提示修改成功4.1 回到首页创建空白模板右上角选择yi-code,然后给他提示词就可以了然后上方点击知识库进行知识库配置可以上传自己需要的内容处理的时候可以这样选择添加完成之后回到聊天机器人4.2 给机器人添加知识库左边的提示词下面哟一个上下文,可以添加知识库,之后就可以正常使用了5. 但是上面的yi-coder不好用所以我用了另外的,ollama run llama3.1:8b这个相比于其他会好用很多。5.1 TEXT EMBEDDING 配置知识库那里的添加,我们也可以选择高质量只是需要配置一个TEXT EMBEDDING添加和上面的那个差不多只是需要选择TEXT EMBEDDING5.2 Ollama配置TEXT EMBEDDINGdmeta-embedding-zhollama pull shaw/dmeta-embedding-zh测试:curl http://localhost:11434/api/embeddings -d '{ "model": "shaw/dmeta-embedding-zh", "prompt": "天空是灰色的" }'返回的内容这样就成功了dify里面正常添加这个就行

dify和ollama使用教程 1. 安装docker这一步百度2. 安装difygit clone https://github.com/langgenius/dify.git cd dify cd docker cp .env.example .env docker-compose up -denv里面可以修改映射的端口,默认是80和443,教程先默认{callout color="#f0ad4e"}EXPOSE_NGINX_PORT=4080EXPOSE_NGINX_SSL_PORT=4443{/callout}2.1 之后访问 localhost/install 进行安装3. 安装Ollama然后我们需要去安装Ollama,官网地址https://ollama.com/安装完ollama后去找适合的模型下载https://ollama.com/search下列我举例一下网友比较推荐的模型{callout color="#e1e1db"}yi Yi 1.5 是一个高性能的双语语言模型。 参数大小:6b9b34b 更新时间:7个月前 适合编程的双语(中文和英文)模型。yi-coder Yi-Coder 是一系列开源代码语言模型,提供少于100亿参数的最先进的编码性能。 参数大小:1.5b9b 更新时间:3个月前 适合编程的双语模型。qwen Qwen 1.5 是由阿里云提供的一系列大型语言模型,参数从0.5B到110B不等。 参数大小:0.5b1.8b4b7b14b32b72b110b 更新时间:8个月前 阿里云提供的模型,可能包含对中文的支持。 qwen2 Qwen2 是阿里集团提供的一系列大型语言模型。 参数大小:tools0.5b1.5b7b72b 更新时间:3个月前 同样可能包含对中文的支持。llama2-chinese Llama 2 基于模型,针对提高中文对话能力进行了微调。 参数大小:7b13b 更新时间:14个月前 专门针对中文对话进行了优化的模型。{/callout}这里的几b是代表着多少亿的参数,个人笔记本建议选择10b以内,不然参数太多了可能会很慢。这里我以yi-coder为例子终端运行ollama run yi-coderollama run yi-coder pulling manifestpulling 8169bd33ad13... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 5.0 GB pulling afc128547699... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 527 B pulling 43070e2d4e53... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 11 KB pulling 3dc12ee097e8... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 135 B pulling a60ed831ae4c... 100% ▕██████████████████████████████████████████████████████████████████████████████████████▏ 485 B verifying sha256 digest writing manifest success >>> 你好Hi, how can I assist you? Please provide more specific information about your request.4.然后dify里面配置模型这里URL填写http://host.docker.internal:11434(因为dify是安装在docker里面的,但是ollama是安装在本机的,所以需要让docker访问ollama的api)点击保存,右上角会提示修改成功4.1 回到首页创建空白模板右上角选择yi-code,然后给他提示词就可以了然后上方点击知识库进行知识库配置可以上传自己需要的内容处理的时候可以这样选择添加完成之后回到聊天机器人4.2 给机器人添加知识库左边的提示词下面哟一个上下文,可以添加知识库,之后就可以正常使用了5. 但是上面的yi-coder不好用所以我用了另外的,ollama run llama3.1:8b这个相比于其他会好用很多。5.1 TEXT EMBEDDING 配置知识库那里的添加,我们也可以选择高质量只是需要配置一个TEXT EMBEDDING添加和上面的那个差不多只是需要选择TEXT EMBEDDING5.2 Ollama配置TEXT EMBEDDINGdmeta-embedding-zhollama pull shaw/dmeta-embedding-zh测试:curl http://localhost:11434/api/embeddings -d '{ "model": "shaw/dmeta-embedding-zh", "prompt": "天空是灰色的" }'返回的内容这样就成功了dify里面正常添加这个就行 -

-

阿里云CDN使用 1. 阿里云配置一个cdn,一切默认就行新建一个cdn,域名就是,泛域名类型的.cdn.example.com源站,因为家里的80和443是没了的,所以使用的是65000,例如:test.example.com:650001.1 基本设置-->ipv6开关可以根据自己的需求设置是否打开1.2 回源配置-->IPv6回源优先使用IPv6-->已开启回源跟随-->未开启回源IPv4/IPv6轮询-->已开启1.3 性能优化-->忽略参数这里需要修改一下,要不然某些参数会被忽略忽略参数-->否2. 新建一个网站默认就行,监听的端口是65000,不是默认的80,配置一个反向代理反代到frps的端口号,比如650803. 对应的服务器上配置frp3.1 frps的配置bindAddr = "0.0.0.0" # 服务端监听端口 bindPort = 52101 # 服务端监听 KCP 协议端口,用于接收配置了使用 KCP 协议的 frpc 连接。 kcpBindPort = 52101 # 在 method 为 token 时生效,客户端需要设置一样的值才能鉴权通过。 auth.token = "token.example" # http端口,不要设置80,否则和宝塔面板的端口号冲突 vhostHTTPPort = 65080 # https端口,不要设置443 vhostHTTPSPort = 65443 # 二级域名后缀 subDomainHost = "cdn.example.com" # 开启frps仪表盘可以检查frp的状态和代理的统计信息。 webServer.addr = "0.0.0.0" webServer.port = 65002 webServer.user = "example" webServer.password = "example" enablePrometheus = true # 日志配置文件 # 日志文件,不指定日志信息默认输出到控制台 log.to = "./logs/cdn-example.log" # 日志等级,可用等级“trace,debug,info,warn,error” log.level = "info" # 日志保存最大时间 log.maxDays = 3 log.disablePrintColor = false # 自定义默认的404页面 custom404Page = "./frp/404.html"3.2 frpc的配置# 用户名,设置此参数后,代理名称会被修改为 {user}.{proxyName},避免代理名称和其他用户冲突。 user = "daimaji" serverAddr = "127.0.0.1" serverPort = 52101 # 登录失败就退出 loginFailExit = true # 控制台日志文件 log.to = "./cdn-example.log" # trace, debug, info, warn, error log.level = "info" log.maxDays = 3 # 当log.to是控制台时禁用日志颜色,默认值为false log.disablePrintColor = false # 认证方式 auth.method = "token" # 令牌 auth.token = "token.example" # 控制面板设置 webServer.addr = "0.0.0.0" webServer.port = 65002 webServer.user = "example" webServer.password = "example" # 将提前建立连接,默认值为零 transport.poolCount = 5 #用于连接到服务器的通信协议 #现在支持tcp、kcp、quic、websocket和wss,默认为tcp transport.protocol = "tcp" #连接服务器时设置客户端绑定ip,默认为空。 #只有当protocol=tcp或websocket时,才会使用该值。 transport.connectServerLocalIP = "0.0.0.0" [[proxies]] name = "测试" type = "http" localIP = "127.0.0.1" localPort = 65003 subdomain = "test"4. 访问测试

阿里云CDN使用 1. 阿里云配置一个cdn,一切默认就行新建一个cdn,域名就是,泛域名类型的.cdn.example.com源站,因为家里的80和443是没了的,所以使用的是65000,例如:test.example.com:650001.1 基本设置-->ipv6开关可以根据自己的需求设置是否打开1.2 回源配置-->IPv6回源优先使用IPv6-->已开启回源跟随-->未开启回源IPv4/IPv6轮询-->已开启1.3 性能优化-->忽略参数这里需要修改一下,要不然某些参数会被忽略忽略参数-->否2. 新建一个网站默认就行,监听的端口是65000,不是默认的80,配置一个反向代理反代到frps的端口号,比如650803. 对应的服务器上配置frp3.1 frps的配置bindAddr = "0.0.0.0" # 服务端监听端口 bindPort = 52101 # 服务端监听 KCP 协议端口,用于接收配置了使用 KCP 协议的 frpc 连接。 kcpBindPort = 52101 # 在 method 为 token 时生效,客户端需要设置一样的值才能鉴权通过。 auth.token = "token.example" # http端口,不要设置80,否则和宝塔面板的端口号冲突 vhostHTTPPort = 65080 # https端口,不要设置443 vhostHTTPSPort = 65443 # 二级域名后缀 subDomainHost = "cdn.example.com" # 开启frps仪表盘可以检查frp的状态和代理的统计信息。 webServer.addr = "0.0.0.0" webServer.port = 65002 webServer.user = "example" webServer.password = "example" enablePrometheus = true # 日志配置文件 # 日志文件,不指定日志信息默认输出到控制台 log.to = "./logs/cdn-example.log" # 日志等级,可用等级“trace,debug,info,warn,error” log.level = "info" # 日志保存最大时间 log.maxDays = 3 log.disablePrintColor = false # 自定义默认的404页面 custom404Page = "./frp/404.html"3.2 frpc的配置# 用户名,设置此参数后,代理名称会被修改为 {user}.{proxyName},避免代理名称和其他用户冲突。 user = "daimaji" serverAddr = "127.0.0.1" serverPort = 52101 # 登录失败就退出 loginFailExit = true # 控制台日志文件 log.to = "./cdn-example.log" # trace, debug, info, warn, error log.level = "info" log.maxDays = 3 # 当log.to是控制台时禁用日志颜色,默认值为false log.disablePrintColor = false # 认证方式 auth.method = "token" # 令牌 auth.token = "token.example" # 控制面板设置 webServer.addr = "0.0.0.0" webServer.port = 65002 webServer.user = "example" webServer.password = "example" # 将提前建立连接,默认值为零 transport.poolCount = 5 #用于连接到服务器的通信协议 #现在支持tcp、kcp、quic、websocket和wss,默认为tcp transport.protocol = "tcp" #连接服务器时设置客户端绑定ip,默认为空。 #只有当protocol=tcp或websocket时,才会使用该值。 transport.connectServerLocalIP = "0.0.0.0" [[proxies]] name = "测试" type = "http" localIP = "127.0.0.1" localPort = 65003 subdomain = "test"4. 访问测试 -

Idea安装codeium排坑(faild download language server) 1. 插件市场搜索安装codeium2. 重启后右下角有这个图标3. 重启IDEA之后,提示faild download language server4. 前往 github.com 下载对应版本的exe程序,版本与插件版本对应,比如上图中我插件的版本是 1.28.1 我就下载1.28.1的exe。5. 把下载好的 language_server_windows_x64.exe 放到插件目录下的一个很长字符串的目录下。这里有一个小技巧,如果你的插件目录不在这里,你可以用Everything软件全盘搜codeium 。最后一串英文,每个人的可能不一样C:\Users\用户名\AppData\Roaming\JetBrains\PyCharm2024.3\plugins\codeium\f740e5605570f4cf2ef1fdda47389168e7319c796. 重启IDEA后提示登录,登录之后便可使用

Idea安装codeium排坑(faild download language server) 1. 插件市场搜索安装codeium2. 重启后右下角有这个图标3. 重启IDEA之后,提示faild download language server4. 前往 github.com 下载对应版本的exe程序,版本与插件版本对应,比如上图中我插件的版本是 1.28.1 我就下载1.28.1的exe。5. 把下载好的 language_server_windows_x64.exe 放到插件目录下的一个很长字符串的目录下。这里有一个小技巧,如果你的插件目录不在这里,你可以用Everything软件全盘搜codeium 。最后一串英文,每个人的可能不一样C:\Users\用户名\AppData\Roaming\JetBrains\PyCharm2024.3\plugins\codeium\f740e5605570f4cf2ef1fdda47389168e7319c796. 重启IDEA后提示登录,登录之后便可使用